L’intelligence artificielle : une révolution technologique à l’empreinte carbone aussi lourde qu’un mammouth dans un magasin de porcelaine

L’Intelligence Artificielle (IA) est en train de bouleverser le monde. De la santé à la finance, elle transforme nos sociétés à une vitesse vertigineuse. Mais derrière cette révolution technologique se cache une réalité bien moins reluisante : un coût environnemental colossal. En s’appuyant sur une puissance de calcul titanesque, l’IA consomme d’énormes quantités d’énergie et de ressources naturelles. Dans un contexte d’urgence climatique, il est impératif de comprendre cet impact et d’explorer les solutions pour rendre l’IA plus durable.

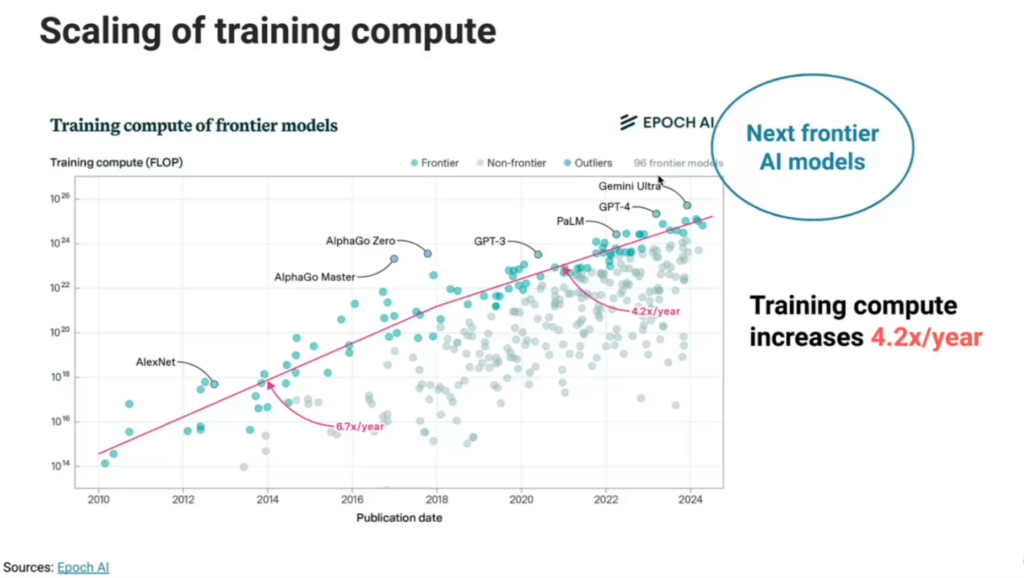

L’entraînement de l’IA : une puissance de calcul hors normes

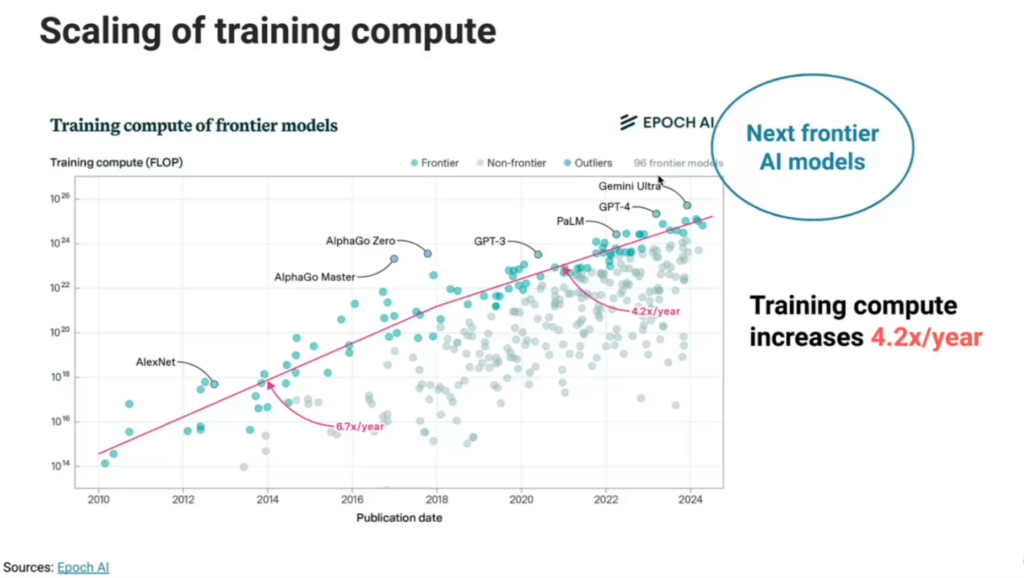

Former un modèle d’intelligence artificielle, c’est comme entraîner un athlète olympique : cela exige des ressources intensives et répétées. Mais dans le cas de l’IA, ces « entraînements » se traduisent par des millions de calculs ajustant des paramètres, avec un coût énergétique astronomique.

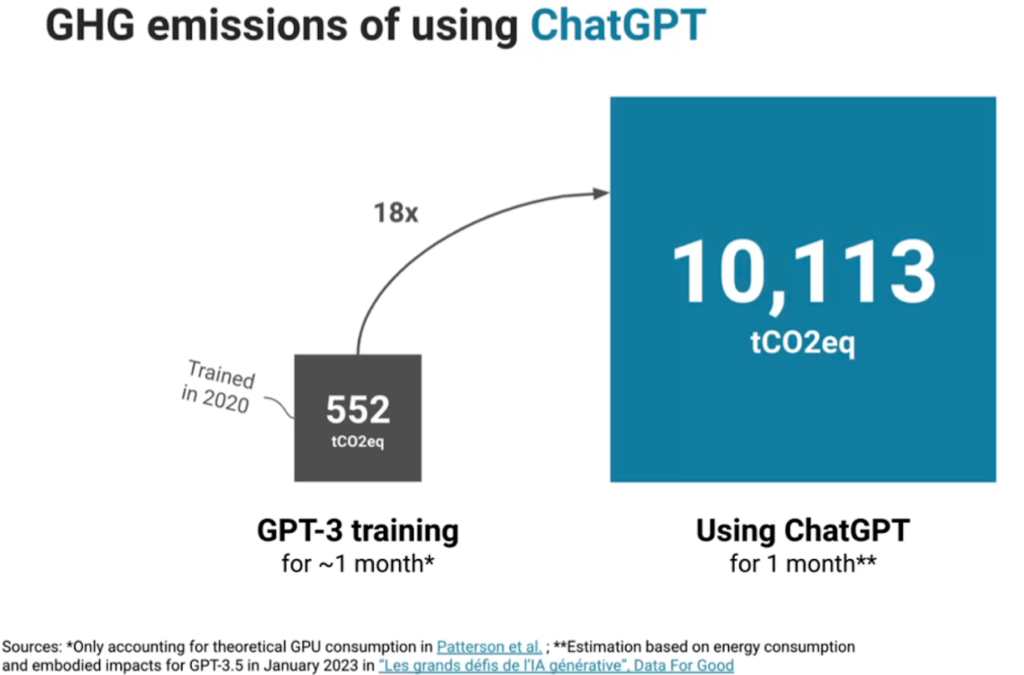

Prenons l’exemple de GPT-3. Son entraînement aurait généré plusieurs centaines de tonnes de CO₂, soit plus que ce qu’une voiture moyenne émet durant toute sa durée de vie. À une époque où chaque kilowattheure compte, ces chiffres interrogent sur la durabilité de cette technologie. Une étude de l’Université du Massachusetts Amherst a révélé que l’entraînement de certains modèles de deep learning peut émettre jusqu’à 284 tonnes de CO₂, l’équivalent de cinq fois l’empreinte carbone annuelle d’un Américain moyen. Une révolution, certes, mais pas franchement « verte ».

Les centres de données : les usines énergivores de l’IA

Les centres de données, véritables « cerveaux » numériques, sont les piliers de l’IA. Ils hébergent les serveurs nécessaires pour stocker, traiter et transmettre nos données. En 2022, ces infrastructures représentaient au minimum 2 % de la consommation mondiale d’électricité, une part comparable à celle de l’industrie aérienne.

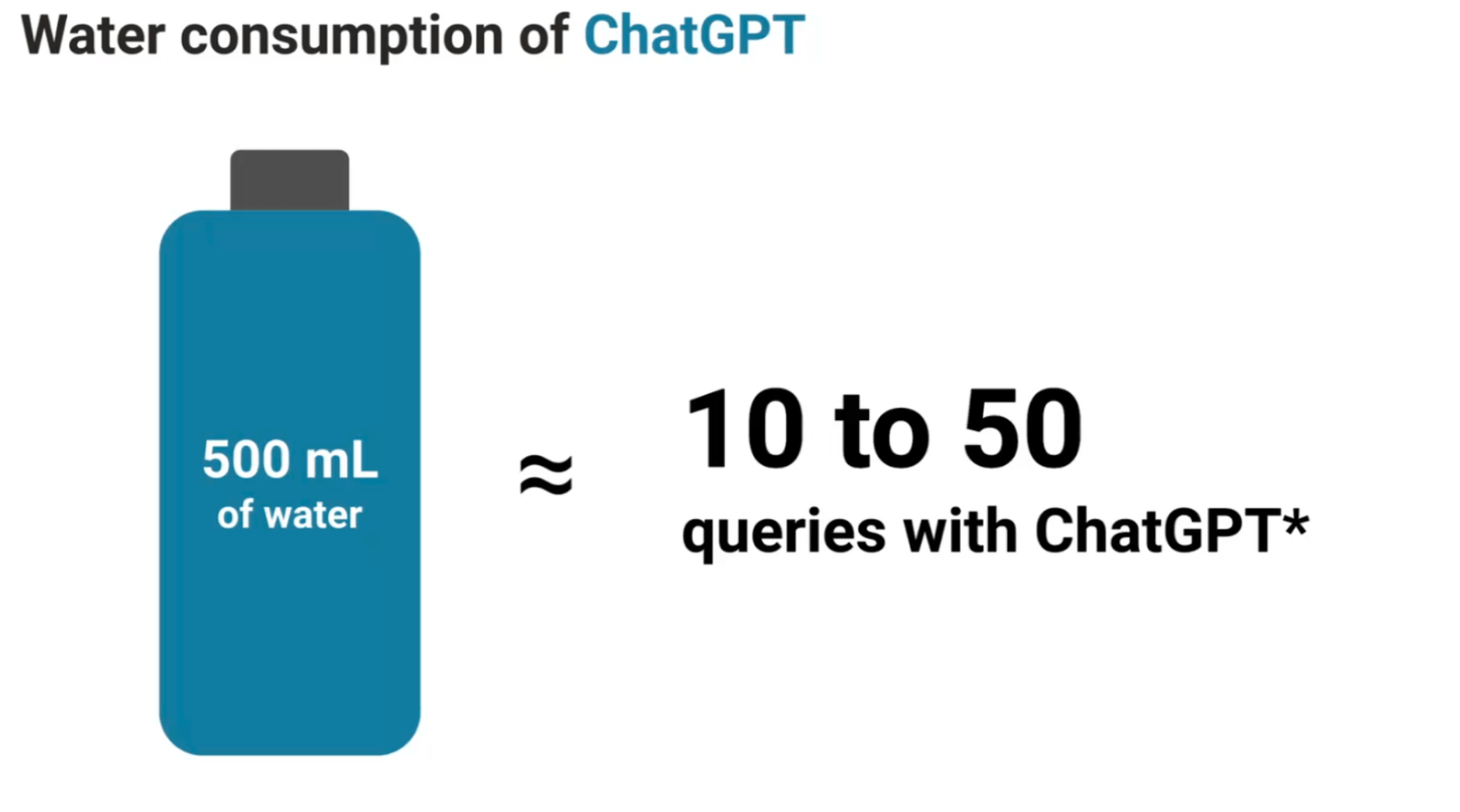

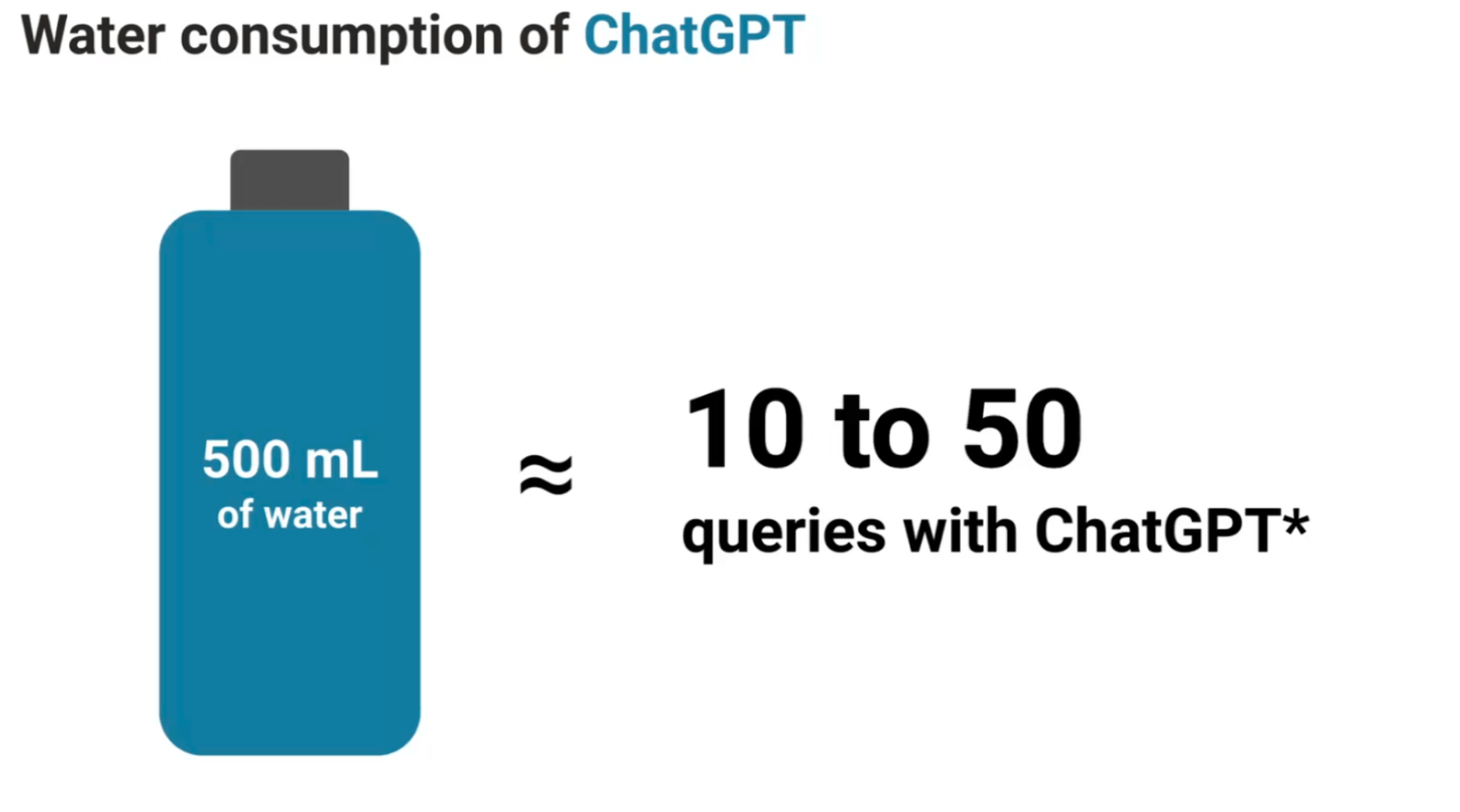

Outre leur consommation d’énergie, ces centres posent des défis supplémentaires liés à leur refroidissement. En Californie, où les sécheresses sont récurrentes, certains centres utilisent des millions de litres d’eau par an pour éviter la surchauffe des serveurs. Ironique, non ? Rafraîchir le numérique pour faire bouillir la planète.

Même nos requêtes les plus simples, comme demander une recette ou générer un e-mail, ont un impact énergétique. “Recherche moi la meilleure recette de lasagnes” : formuler une requête détaillée pour obtenir une recette spécifique peut consommer environ 2,9 wattheures (Wh) d’électricité. “Rédige-moi un e-mail de 100 mots” : demander à ChatGPT de rédiger un e-mail court nécessite une quantité d’énergie suffisante pour allumer 14 ampoules LED pendant une heure. Multipliez cela par des millions d’utilisateurs, et l’impact devient difficile à ignorer.

Une demande énergétique insoutenable

La croissance exponentielle de l’intelligence artificielle générative (GenAI) exerce une pression sans précédent sur les infrastructures énergétiques mondiales. Selon Gartner, d’ici 2027, 40 % des centres de données dédiés à l’IA pourraient être confrontés à des pénuries d’énergie, incapables de répondre à la demande croissante

Cette situation résulte de la consommation énergétique massive requise par les modèles d’IA, qui dépasse les capacités actuelles de production et de distribution d’électricité. Sans une adaptation rapide des infrastructures énergétiques et une optimisation de l’efficacité énergétique des centres de données, le déploiement à grande échelle de l’IA pourrait être freiné par des limitations énergétiques majeures.

Les GPU : des moteurs puissants au coût écologique élevé

Les processeurs graphiques (GPU), indispensables pour les calculs complexes, sont au cœur des progrès de l’IA. Pourtant, leur empreinte environnementale est loin d’être négligeable. L’entraînement de certains modèles peut nécessiter jusqu’à 1 000 mégawattheures, l’équivalent de la consommation mensuelle de centaines de foyers.

Ces GPU ne sont pas seulement gourmands en énergie : leur fabrication dépend de métaux rares comme le lithium et le cobalt. Ces ressources sont souvent extraites dans des conditions désastreuses, tant sur le plan environnemental qu’humain. En République démocratique du Congo, par exemple, l’exploitation du cobalt a provoqué des conflits armés et des violations des droits humains.

Mesurer l’impact pour mieux agir

Avant de réduire l’impact environnemental de l’IA, encore faut-il être capable de le mesurer avec précision. Une analyse fine des consommations énergétiques des centres de données, des serveurs et des modèles d’IA eux-mêmes est essentielle pour identifier les points d’optimisation prioritaires. Cela inclut le suivi des émissions de CO₂ liées à chaque phase, depuis l’entraînement des modèles jusqu’à leur utilisation quotidienne. En adoptant des outils de mesure en temps réel, les entreprises peuvent prendre des décisions éclairées pour réduire leur empreinte écologique tout en maintenant leurs performances. Ce travail de mesure constitue le premier pas vers une IA véritablement durable.

L’optimisation des modèles : faire plus avec moins

Malgré ces défis, des solutions émergent pour rendre l’IA moins énergivore. Les chercheurs innovent pour réduire l’empreinte carbone des modèles d’IA, et plusieurs stratégies se démarquent :

Compression des modèles : Des techniques comme le “pruning” permettent de réduire la taille des réseaux neuronaux en éliminant les connexions inutiles, diminuant ainsi leur complexité et leur consommation énergétique. Certaines approches ont permis de réduire jusqu’à 90 % la taille de modèles sans perte significative de précision.

Quantification : En abaissant la précision des calculs (par exemple, de 32 bits à 16 bits), on réduit drastiquement la consommation d’énergie. Les cœurs Tensor de NVIDIA, spécialement conçus pour ces calculs, illustrent cette tendance en optimisant l’efficacité énergétique.

Distillation de modèle : Cette technique consiste à former un modèle plus petit (« élève ») à partir des connaissances d’un modèle plus grand (« enseignant »). Résultat : des performances similaires, mais avec une empreinte écologique réduite.

Vers une IA alimentée par le vent, le soleil et le nucléaire

Les géants de la tech ne sont pas en reste pour réduire l’impact environnemental de leurs infrastructures. Google, par exemple, compense depuis 2017 l’intégralité de sa consommation électrique mondiale avec des énergies renouvelables. L’entreprise vise également à fonctionner exclusivement avec de l’énergie sans carbone 24h/24 et 7j/7 d’ici 2030.

De son côté, Microsoft intensifie ses efforts pour atteindre son objectif de couvrir 100 % de ses besoins énergétiques avec des sources décarbonées d’ici 2025. En plus de sa collaboration avec Brookfield Asset Management sur des projets énergétiques totalisant 10,5 gigawatts, l’entreprise a franchi une nouvelle étape stratégique en investissant directement dans des centrales nucléaires. En rachetant ces infrastructures, Microsoft garantit une source d’énergie fiable et à faible empreinte carbone pour alimenter ses centres de données, dont la consommation explose avec l’essor de l’intelligence artificielle. Un choix qui illustre une tendance majeure où le nucléaire devient un pilier clé pour répondre aux exigences énergétiques des technologies de demain.

Ces chiffres, bien qu’impressionnants, restent des estimations. Ils varient fortement en fonction des méthodologies employées, des régions géographiques et des hypothèses d’efficacité. Ils révèlent l’urgence d’une IA plus frugale et d’une évaluation rigoureuse de son impact environnemental.

Rédigé par Olivia DENIS